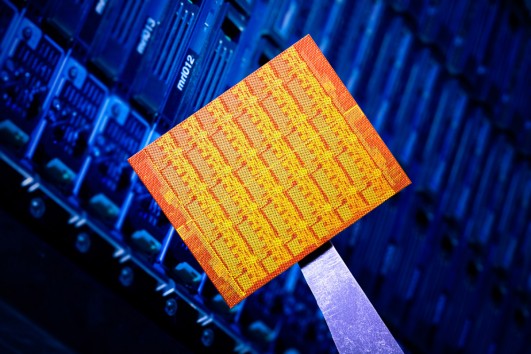

Der Prozessor der Zukunft soll eine ganze Wolke von Kernen haben. Intel stellt einen On-Chip-Cluster mit 48 unabhängigen x86-Kernen vor.

Auf der Suche nach immer mehr Rechenleistung sind die Ingenieure des Prozessorenherstellers Intel bei 48 Kernen angelangt. Der für die Forschung in diese Richtung entwickelte Single-Chip Cloud Computer (SCC), Codename „Rock Creek“, soll den Durchbruch zu nie dagewesener Rechenleistung auf kleinstem Raum bringen. Denn der Prozessorenbau steuert auf eine Grenze zu. Als die Erhöhung der Taktraten nebst Verkleinerung nicht mehr sinnvoll möglich war, begannen Intel und Co. damit, Zweikernprozessoren zu bauen, um weiter an der Leistungsspirale zu drehen. Heute sind Vierkernprozessoren State of the Art, im nächsten Jahr gelangen Prozessoren mit sechs und acht Kernen in den Consumer-Markt. Diese Entwicklung kann jedoch nicht endlos so weitergehen. Das Problem sind die schnellen Zwischenspeicher (Cache), die praktisch jeder moderne Prozessor verwendet, damit ihn der langsamere Hauptspeicher (RAM) nicht ausbremst. Ein Cache ist also so etwas wie ein schnell verwendbarer Notizzettel am Arbeitsplatz des Prozessorkerns. Wenn er allein ist — kein Problem. Kommen Kollegen hinzu, wird es komplizierter. Der Kollege könnte die Daten im Hauptspeicher, mit denen ein Kern rechnet, in der Zwischenzeit verändert haben, was alles zunichte macht. Wie im Büroalltag müssen sich mehrere Kerne also absprechen, damit am Ende etwas Vernünftiges herauskommt. Diese minutiösen Absprachen skalieren aber schlecht. Zwei, drei, vier, sechs, acht Leute sind ein Team, mehr Leute sind ein Arbeitshindernis. Die Absprachen erreichen irgendwann Ausmaße, die den Leistungszugewinn völlig zunichte machen können, einige Operationen dauern dann gar um den Faktor 1000 länger. Auch das kennt jeder Angestellte einer größeren Firma.

Ein Vorschlag für die Zukunft lautet daher: Werfen wir die Cache-Absprachen-Hardware bisheriger Multicore-Lösungen über Bord und gehen hin zu einer Architektur, wie sie die vernetzten Cluster in Rechenzentren haben. Dort stehen viele Rechner, die zusammen vernetzt an einem Problem arbeiten. Jeder Rechner kann im Prinzip ein anderes Betriebssystem ausführen, und dasselbe gilt für SCC. In einem Cluster spricht sich ein Knoten nicht für jeden Piep mit jedem ab, sondern er erhält ein Problem oder ein Teilproblem, das er allein und in Eigenverantwortung abarbeitet. Was auf seinen Notizzetteln steht, interessiert die anderen Mitarbeiter nicht. Hauptsache, das Ergebnis stimmt. Man versucht kurz gesagt, jeden Einzelnen so viel wie möglich in Ruhe arbeiten zu lassen, indem er so wenig wie möglich absprechen muss. Mit dieser Herangehensweise fahren wissenschaftliche Hochleistungsrechencluster seit langem gut, allerdings verlangt sie vom Programmierer deutlich mehr. Jeder Knoten kann im Extremfall etwas vollkommen anderes tun, und diese Flexibilität will erstmal organisiert werden. Für die Kohärenz, die vorher penibel in Hardware festgelegt war, muss sich dann jedenfalls die Software und damit der Programmierer kümmern.

Die einzelnen Kerne von Intels SCC sind abgewandelte x86-Prozessoren, wie wir sie zum Beispiel aus der Pentium-Reihe kennen. Klingt vielleicht zunächst nebensächlich, ist aber die eigentliche Sensation. Denn durch die bekannte Architektur der Einzelkerne erreicht Intel, dass viele der vorhandenen Entwicklungswerkzeuge weiter funktionieren, bestehende Software zum Laufen gebracht werden kann. So gibt es außer Intel noch die kalifornische Startup-Firma Tilera, die eigene Clusterchips für Hochleistungsanwendungen wie etwa Multimediaberechnungen bereits verkauft. Die Tilera-Zusatzkarten (PCI Express) kosten derzeit einige tausend US-Dollar und Tilera kündigt gar schon den 100-Kern-Chip an. Auch Intel präsentierte 2006 einen 80-Kern-Chip, dessen 80 Recheneinheiten jedoch auf reine Gleitkommaoperationen spezialisiert waren. Jetzt jedoch gibt es erstmals 48 vollwertige, bekannte x86-Prozessoren, und damit theoretisch ein Vielfaches der Leistung heutiger Prozessoren.

Theoretisch deshalb, weil immer etwas Verwaltung anfällt. Addiert man die Einzelrechenleistungen der Kerne und subtrahiert den Verwaltungsaufwand, erhält man die Nettorechenleistung. Bei den besten Superclustern erreicht diese derzeit bis über 80 Prozent der addierten Leistung. Da bei SCC alle Knoten kommunikationsgünstig auf demselben Chip liegen, könnte die maximale Nettoleistung dort nochmals deutlich höher liegen. Je nach Problem und programmiererischer Kompetenz kann die Nettoleistung in der Praxis jedoch auch unter 10 Prozent sinken. Das Attraktive an so einem Cluster-Chip bleibt jedoch, dass zusätzliche Kerne auf einfache Weise die Rechenleistung des Gesamtsystems heraufsetzen. Es gibt keine unmittelbaren Skalierungsgrenzen (Erfahrungen mit Clustern zeigen, dass selbst mehrere tausend Knoten noch Sinn machen) und die in modernen Betriebssystemen implementierten Energiesparmaßnahmen greifen: Die Software schickt Kerne, die gerade nicht benötigt werden, in den Ruheschlaf. Jeder Kern kann außerdem auf einer unterschiedlichen Taktfrequenz arbeiten und Bänke zu jeweils vier Kernen können sogar mit unterschiedlichen Spannungen betrieben werden. All das spart Energie. Der SCC sieht dazu entsprechende Steuersignale vor und kommt auf eine lastabhängige Leistungsaufnahme zwischen 25 und 125 Watt. Damit liegt die Verlustleistung in etwa auf dem Niveau heutiger Intel-Prozessoren, das aber bei zehn- bis zwanzigfacher Rechenleistung.

Das Thema Energiesparen kommt bei Prozessoren einerseits zum Tragen, wenn es um mobile Geräte geht, die mit der in Akkus gespeicherten Energie auskommen müssen. Es geht aber außerdem um die Vermeidung von nutzloser Hitze und generell um die übergeordneten Zusammenhänge. Zahlreiche Stimmen kritisieren den steigenden Flugverkehr ob seiner Klimabilanz. Was dabei gern vergessen wird: Unsere Arbeits- und Unterhaltungselektronik trägt mit fast derselben Größe zu ebendieser Bilanz bei. Vor diesem Hintergrund darf es erfreuen, wenn die Zeiten minimalster Systemauslastung über längste Zeiten ihrem Ende entgegengehen.

Intel will vom SCC zunächst einmal nur wenige hundert Stück herstellen, um diese an Forschungseinrichtungen weltweit zu verteilen. Das Ziel der Aktion ist es, Probleme wie Chancen der neuen Architektur auszuloten. Ein Projekt namens Barrelfish läuft an der ETH Zürich. Barrelfish ist ein Betriebssystem, das auf die speziellen Anforderungen kommender Cluster- und Multicore-Systeme ausgelegt ist. Das ETH Zürich kooperiert dabei mit Microsoft Research Cambridge. Das Interesse von Microsoft kommt nicht von ungefähr. Cluster-Chips sind die wahrscheinlichste Lösung für aktuelle Prozessorprobleme, und je früher man dabei ist, desto besser. Ob wir in Zukunft ein angepasstes „Windows for Clustergroups“ oder etwas ganz Neues sehen werden, ist derzeit noch völlig offen.

Die typischen Kandidaten für immer mehr Rechenleistung sind Wettersimulationen, CAD-Workstations, 3D-Berechnungen in Filmen oder Spielen und natürlich die Grundlagenforschung mit ihren Superclustern. Einige weniger typische Kandidaten dürfen zu diesem Anlass jedoch ebenfalls wieder aus ihrem Schrank. Das 3D-Internet, das über die Jahre an immer anderen Hindernissen hing, wird derzeit von Intel stark gepusht. Modefirmen sehen schon jetzt das Potenzial rundum betrachtbarer Produkte. Auch die rechenintensive Künstliche Intelligenz wird für den Alltag wieder relevanter. Oder es könnte ganz neue Benutzerschnittstellen geben. Intel schlägt etwa vor, ein intelligentes Kamerasystem mit 3D-Modeangeboten zu verbinden, sodass sich der Kunde an seinem Rechner in Echtzeit berechnet betrachten könnte. Oder die Schnittstelle zwischen Mensch und Maschine: Derart leistungsfähige Computer könnten über Kameras die Bewegungen des Nutzers sehen, verstehen und darauf reagieren. Oder sie könnten gleich Gehirnstrommuster auswerten, sodass ein Diktat in der Stille des eigenen Bewusstseins stattfinden könnte statt wie heute per Spracherkennung. Oder das sogenannte Sport-Mining: Ein Videorekorder zeichnet eine Fußballübertragung nicht nur auf, sondern versteht sie auch. Im Nachhinein kann der Zuschauer dann seine Aufzeichnungen durchgehen, sie nach Ballbesitz und Toren durchgehen. Effektiv steht jedem Fan damit ausführliches Expertenwissen zur Verfügung. Ähnliches gilt für die Finanzen. In naher Zukunft könnten Haushalts-PCs mit der entsprechenden Software ebenso umfangreiche wie tiefgehende Börsenanalysen allein erledigen.

Der Einwand „braucht keiner“ fällt bei einem technischen Sprung dennoch gerne. Bei PCs lechzen zumindest die Zocker immer nach noch mehr Leistung. „Aber auch der normale Nutzer wird langfristig wie selbstverständlich unglaubliche Rechenleistungsreserven am Schreibtisch stehen haben“, sagt Andreas Stiller, Prozessorenexperte beim Computermagazin c‘t. „Die Interfaces werden sich der gebotenen Leistung anpassen, die Anwendungen ebenfalls. Cluster-Computing war früher die Domäne der Supercomputer. Was man nicht vergessen sollte ist daher: Die Rechenleistung, die heute auf jedem Schreibtisch steht, ja sogar in jedem Telefon HiFi-Klingelsamples abspielt, gehörte vor gar nicht allzu langer Zeit ebenfalls noch in die Domäne der Supercomputer.“